AI(人工知能)同士が同じゲームに参加したら、協力するのか、戦うのか!?

公開: 更新:

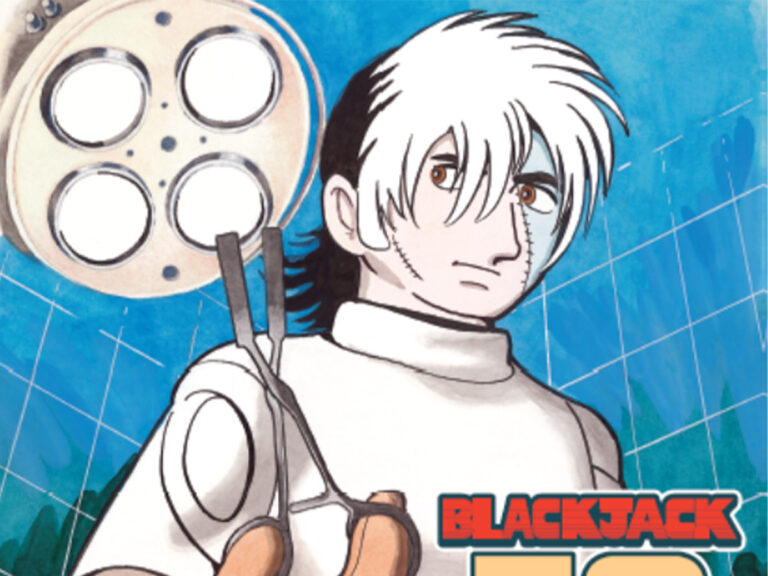

手塚治虫の名作『ブラック・ジャック』の新作発表へ AIとの共同制作に賛否両論まるで人間のように自然な文章を書く対話型AIや、特徴を伝えると、数秒でハイクオリティな画像を生み出す画像生成AIなど、近年革命的な進歩を遂げているAI技術。幅広い一般知識と問題解決能力も備えており、あらゆる分野での活躍が期待されています。

AIが自分で考えてイラストを描く! その繊細なタッチに「ま、負けた…」AI(人工知能)の話題が多い中、AIの中でもいまもっとも注目されている分野があるんですが、その技術を使ってアメリカ・マイクロソフト社の人工知能ラボ『マイクロソフト・リサーチAI (Microsoft Research A...

- 出典

- DeepMind

昨年人間のプロ棋士を破って一躍有名になった「AlphaGo(アルファ碁)」を開発する、Google傘下のデイープマインド社が、性能に差がある2つのAI(人工知能)があるひとつのゲームに参加したとき、協力し合うのか、それとも戦うのかの実験を行ったと発表しました。

これはいわゆるゲーム理論の有名な例に「囚人のジレンマ」というのがあって、お互い協力する方が協力しないよりもよい結果になることが分かっていても、協力しない者が利益を得る状況だと、互いに協力しなくなる・・・というジレンマのことで、数学者のアルバートタッカーという人が証明したものなんですが、それが果たしてAIでも起きるのかという実験なんです。

「囚人のジレンマ」は例えば、囚人2人に「おまえら2人とも黙秘したら2人とも懲役2年だ」「もし一人だけ自白すればその場で釈放してやるが、自白しなかったほうは懲役10年だ」「ふたりとも自白したら2人とも懲役5年」

こうなった場合、人間はどうするのか・・・。これで言えば、相手が確実に黙秘すると信じれば、自分は自白してしまえば釈放、ただし相手を裏切ることになる。相手が黙秘するか自白するかわからないなら、自白したほうが10年にならないで済むので良いが、これも相手を裏切る可能性がある・・・。

これと同じような状況をゲームで再現し、人工知能にやらせてみたというんです。

発表によれば、例えば、りんごがいっぱいある場所で互いにレーザーを当てて相手を一時的に動けなくさせながら、りんごを多く取ったほうが勝ちというもので、このときは、りんごがなくなるまではレーザーを打つことはなかったが、だんだん少なくなると打ち合いが始まって、最後は両者ともずっと身動きが取れない状態が続いたそうです。

このようなゲームを何千回と続け、深層学習させていったところ、状況に応じて、協力し合ったり競争したりまちまちだったという結果になったそうなんです。つまりゲームの状況が競争や協力を引き起こしている、これって何の事はない、人工知能にどんな状況でもこうしなさいとか、ちゃんとルールを教えてやらないと、必ずしも良い結果を導き出せる働きはしない!!ということがわかったというわけです。

結局、人工知能は、人間がちゃんとルールを作ってやらなければ、全くダメダメだってこと。まだまだ人間が出る幕はありますよ!! 人間が作ったものは人間がサポートしてあげてこそのAIなんじゃないんでしょうか。

[文/構成 土屋夏彦/grape編集部]

土屋夏彦

上智大学理工学部電気電子工学科卒業。 1980年ニッポン放送入社。「三宅裕司のヤングパラダイス」「タモリのオールナイトニッポン」などのディレクターを務める傍ら、「十回クイズ」「恐怖のやっちゃん」「究極の選択」などベストセラーも生み出す。2002年ソニーコミュニケーションネットワーク(現ソニーネットワークコミュニケーションズ株式会社)に転職。コンテンツ担当ジェネラルプロデューサーとして衛星放送 「ソネットチャンネル749」(現アジアドラマチックTV★So-net)で韓国ドラマブームを仕掛け、オンライン育成キャラ「Livly Island」では日本初の女性向けオンラインで100万人突破、2010年以降はエグゼクティブプロデューサー・リサーチャーとして新規事業調査を中心に活動。2015年早期退職を機にフリーランス。記事を寄稿する傍ら、BayFMでITコメンテーターとしても出演中、ラジオに22年、ネットに10年以上、ソーシャルメディア作りに携わるメディアクリエイター。